Un inizio promettente

L’esempio riportato nel paragrafo precedente con protagonisti ELIZA e PARRY mostra come sia praticamente impossibile simulare un comportamento intelligente implementando un algoritmo discreto che associ un output “intelligente” ad un insieme arbitrariamente grande di casi reali. Certamente è possibile creare dei sistemi esperti in grado di associare un risultato ottimale ad un limitato insieme di casi ben codificati, ma la versatilità e adattabilità di un sistema veramente intelligente è completamente fuori della portata di questo tipo di soluzione.

Tuttavia, diversi anni prima, nel tentativo di creare un modello funzionale del cervello e del sistema nervoso alcuni studiosi gettarono le basi di ciò che oggi associamo all’intelligenza artificiale.

Nelle foto sotto vediamo, da sinistra verso destra, il neurofisiologo Warren McCulloch, il matematico Walter Pitts e lo psicologo Frank Rosenblatt il cui contributo pionieristico gettò le basi per le moderne reti neurali artificiali.

Il contributo seminale dei primi due studiosi fu la pubblicazione, nel 1943 dell’articolo A Logical Calculus of Ideas Immanent in Nervous Activity in cui viene dimostrato come la natura tutto-o-niente del comportamento dei neuroni permette di trattare le reti di neuroni con i mezzi della logica proposizionale (cioè la logica che fa uso dei connettivi logici AND, OR, NOT).

Il modello proposto dai due scienziati era una versione altamente semplificata della sua controparte biologica descritta nel paragrafo precedente. Il neurone di McCullogh-Pitts è un aggregatore di stati binari tale che, quando il bilancio fra stati eccitatori e inibitori superi una certa soglia, manifesti un’attivazione dello stato di output, anch’esso binario, 1 o 0.

Pochi anni dopo, nel 1957, arrivò il contributo di Rosenblatt che riuscì a simulare sul suo IBM704 il primo modello di neurone informatizzato, il Percettrone.

Il modello di Rosenblatt prevedeva una rete costituita delle cosiddette unità “S” (Sensory System in quanto collegato a dei veri e propri sensori fisici), delle unità “A” (Associative System in quanto incaricate di collegare le unità di ingresso e quelle di uscita) e delle unità “R” (Response System che restituivano il segnale elaborato). Il funzionamento di questi elementi è sostanzialmente binario, in cui ognuno reagisce con un’uscita +1 o -1 in funzione del fatto che il dato in ingresso, sia esso un segnale di un sensore esterno o interno alla rete stessa, fosse o meno superiore ad una certa somma. Nel suo Perceptrons and the theory of brain mechanisms del 15 marzo 1961, Rosenblatt introduce dei coefficienti di accoppiamento fra le unità S e A che sarebbero oggetto di un sistema di rinforzo attraverso il quale la rete sarebbe in grado di perfezionare il suo output. Il metodo con cui avviene l’aggiornamento di tali coefficienti (detti “pesi“) costituisce il cosiddetto algoritmo di apprendimento ed è una discriminante importante per descrivere il funzionamento di ciascuna tipologia di rete neurale artificiale.

In una rete come quella descritta, si usa un tipo di apprendimento detto supervisionato in cui si presenta alla rete un dato e si modificano le sue “sinapsi”, cioè i pesi che simulano il collegamento fra i neuroni, finché l’uscita non raggiunge lo stato atteso.

Gli elementi che saranno alla base della moderna concezione delle reti neurali artificiali c’erano tutti. Il percettrone era in in grado di simulare le funzioni base della logica proposizionale e i primi risultati nel riconoscimento di semplici immagini erano incoraggianti.

Tuttavia la pubblicazione nel 1969 del libro Perceptrons ad opera di Marvin Minsky e Seymour Papert gettò l’intero campo di studi nella stagnazione per decenni.

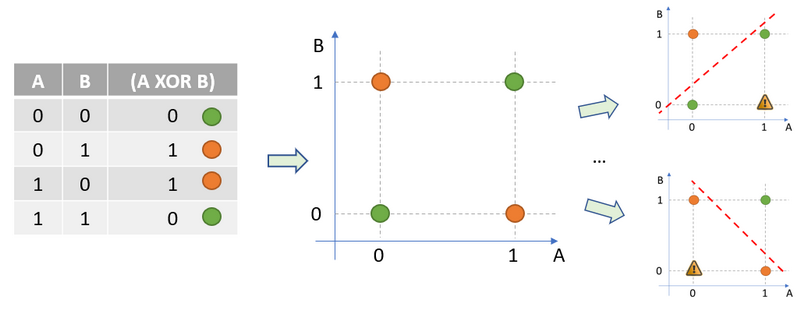

Nel libro gli autori dimostrarono che il percettrone non era in grado di risolvere problemi in cui lo spazio degli ingressi non fosse linearmente separabile. Semplificando, un problema in cui i dati che portano ad una data soluzione siano mischiati a quelli che portano ad una soluzione differente non sono risolubili attraverso il semplice modello di percettrone proposta da Rosenblatt. Un esempio molto semplice è la funzione logica XOR.

Come si può vedere dalla rappresentazione grafica del problema, non è possibile separare con una linea le combinazioni che danno un risultato verde (rappresentante lo 0 logico), da uno rosso (che rappresenta l’1 logico).

Nel loro libro, Minsky e Papert esprimono scetticismo sul fatto che tale problema sarebbe stato risolubile tramite quelle che oggi chiamiamo reti multistrato e questo, unito al prestigio di cui gli autori godevano nella comunità scientifica fu sufficiente a frenare pesantemente gli investimenti in questo campo di ricerca.

Purtroppo Roseblatt morì poco dopo, nel 1971, e non ebbe tempo di proseguire gli studi che oggi sappiamo avrebbero portato a ribaltare le conclusioni di Minsky e Papert.

Il risveglio dal torpore in cui era caduta la ricerca nel campo delle reti neurali avvenne nel 1982 grazie al lavoro del fisico statunitense John Hopfield il quale, ad imitazione ancora una volta delle reti neurali biologiche, propose un tipo di rete in cui i neuroni sono tutti interconnessi fra di loro e mostrò che tale modello è capace di realizzare delle memorie associative, applicabili per esempio al riconoscimento delle immagini.

Tali reti, che oggi si chiamiamo reti di Hopfield, sono in grado infatti di riconoscere delle immagini deteriorate o incomplete una volta che siano state addestrate presentando loro la versione completa.

Tali reti, che oggi si chiamiamo reti di Hopfield, sono in grado infatti di riconoscere delle immagini deteriorate o incomplete una volta che siano state addestrate presentando loro la versione completa.

Il modello di apprendimento utilizzato nelle reti di Hopfield, contrariamente a quello visto poco sopra, è di tipo non supervisionato, in cui si presenta il dato di input alla rete e si calcola una sorta di energia interna modificando i pesi finché l’energia non raggiunge un valore minimo.

Il lavoro di Hopfield, che pure faceva uso di un tipo di rete leggermente diverso da quello di Rosenblatt, inaugurò una nuova era nella ricerca delle reti neurali e, nel prossimo paragrafo, vedremo alcuni concetti che ne sono alla base.

-0

-0  )

)

Lascia un commento